Este ora 23:30 când scriu asta. Lucrez la o automatizare a fluxului de lucru și am avut nevoie de asistență de la DeepSeek-R1 cu unele probleme provocatoare. Dar, din păcate, continuă să spună „ Serverul este ocupat; vă rugăm să încercați din nou mai târziu. „Devin nerăbdător și frustrat.

Ai mai fost și tu în această situație, nu? Deci, să abordăm această problemă rulând modelul pe computerul nostru local. Dar cum?

Credeți-mă, este un proces simplu în trei pași care nu ar trebui să vă ia mai mult de 15 minute.

În acest articol, nu voi descărca pur și simplu modelul și nu voi începe să-l întreb în terminal, deoarece nu este foarte ușor de utilizat și avem nevoie de o interfață de utilizare precum ChatGPT în care să putem introduce intrări și să obținem rezultate într-un mod foarte atrăgător din punct de vedere vizual.

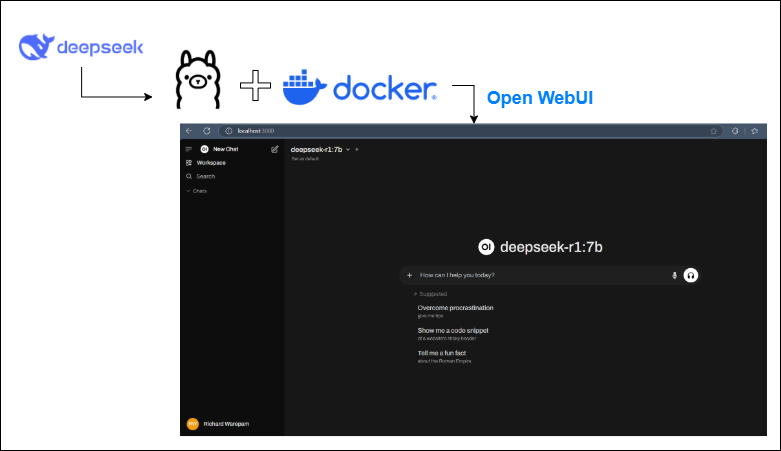

Nu sună grozav? Iată cum plănuim să o facem:

- Instalați Ollama, care ne permite să descărcam orice model și să lucrăm cu el local pe computerul nostru.

- Apoi, folosind Docker, vom instala un Open WebUI care oferă o experiență de chat bazată pe browser. Deci, avem nevoie de Docker...

- Asta este; pur și simplu găzduim pe localhost, selectăm modelul pe care îl dorim și începem să folosim modelul pentru munca noastră.

Pasul 1: Instalarea Ollama (coloana vertebrală AI locală)

Ollama oferă baza pentru rularea locală a modelelor precum DeepSeek-R1. Ollama funcționează perfect cu instrumente precum FlowWise și N8N, ceea ce îl face excelent pentru dezvoltatori.

Descărcați Ollama . Vizitați site-ul oficial Ollama și descărcați versiunea corespunzătoare pentru sistemul dvs. de operare.

Obțineți modelul DeepSeek:

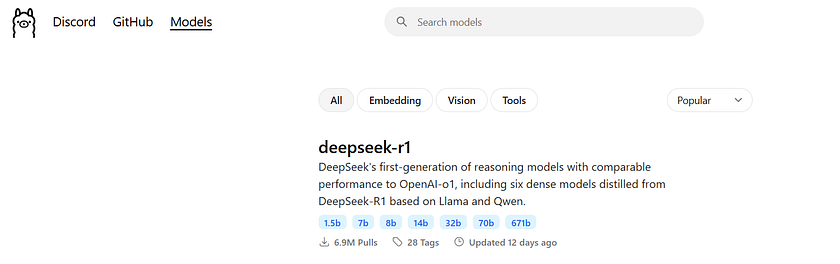

- Deschideți interfața Ollama, apoi accesați Modele și alegeți DeepSeek R1.

- Sfat profesionist: Începeți să utilizați modelul de parametri 7B (potrivit pentru GPU-uri de nivel mediu, cum ar fi RTX 4070). Dacă nu aveți hardware de nivel enterprise, evitați versiunea mare 671B.

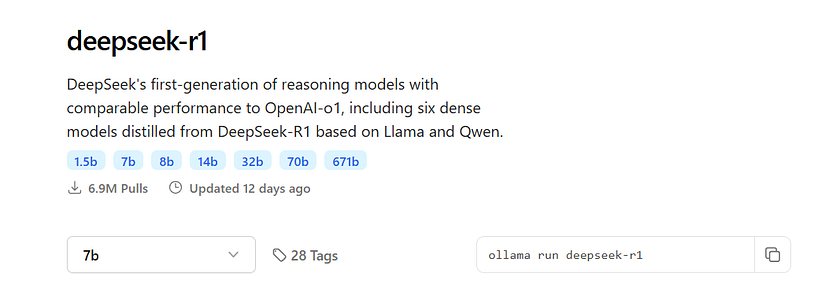

- Copiați și inserați comanda de descărcare a modelului (de exemplu, ollama pull deepseek-r1–7b) în terminalul dvs.

ollama run deepseek-r1:7b

#sau asta:

ollama pull deepseek-r1:7bPasul 2: Configurați Open WebUI (Interfața magică)

Open WebUI convertește rezultatul terminalului Ollama într-o interfață de chat fluidă, bazată pe browser. Iată cum să-l implementați cu Docker:

Instalați Docker : descărcați și rulați Docker Desktop.

Implementați Open WebUI : apoi copiați următoarea comandă Docker (schimbați portul după cum este necesar):

docker run -d -p 5000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainDe ce portul 5000? Evitați problemele cu aplicațiile care folosesc portul 3000 (care este popular pentru instrumentele de dezvoltare web).

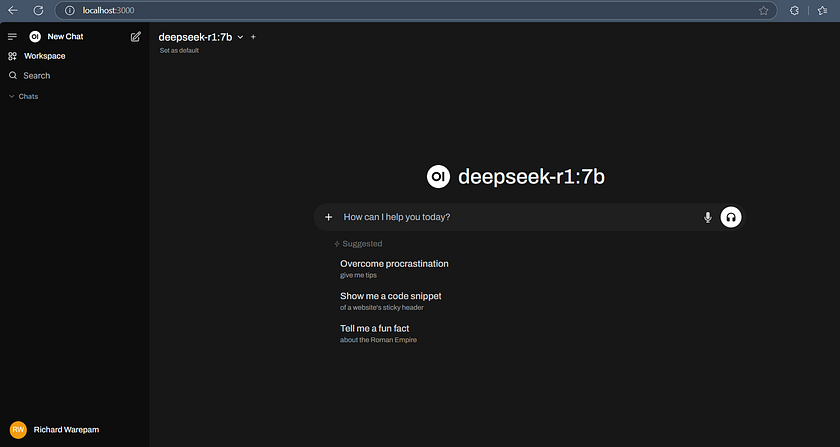

Lansare și autentificare:

- Open WebUI poate fi accesat la http://localhost:5000.

- Creați un cont local ( nu este necesar internetul! ).

Pasul 3: Utilizați DeepSeek R1 ca un profesionist.

La conectare:

- Selectați modelul dvs.: selectați varianta DeepSeek pe care ați descărcat-o (de exemplu, DeepSeek-R1–7B).

- Începeți să discutați: puneți întrebări, generați idei și testați interogări complexe.

Astfel: „ Rezumați legile de scalare ale modelelor de învățare prin întărire .”

Caracteristici interesante:

- Pași de raționament: Extindeți „gândirea” modelului pentru a-și dezvălui logica în mijlocul unui răspuns.

- Gestionarea conversațiilor: puteți redenumi cu ușurință chaturile, puteți începe fire noi sau le puteți revedea pe cele existente.

De ce această configurație este foarte bună

- În primul rând confidențialitatea : datele dvs. rămân pe computer.

- Flexibilitate hardware : modele la scară bazate pe puterea GPU-ului dumneavoastră.

- Utilizabil pentru dezvoltatori : Integrați cu instrumente de automatizare precum N8N pentru fluxuri de lucru avansate.

În concluzie, rularea DeepSeek-R1 local pe computerul dvs. este un proces simplu care vă îmbunătățește fluxul de lucru, oferind o interfață ușor de utilizat și menținând confidențialitatea datelor.

Prin instalarea Ollama și configurarea Open WebUI cu Docker , puteți implementa și utiliza cu ușurință modelul pe mașina dvs. locală. Această configurație oferă flexibilitate, confidențialitate și integrare cu instrumente de automatizare, ceea ce o face o alegere excelentă pentru dezvoltatori, pasionații de date și pasionații de AI.

Articol tradus dupa https://blog.gopenai.com/how-to-run-deepseek-r1-locally-on-your-computer-c0a297bfd59e

Comentarii

Trimiteți un comentariu